GPTとは何か Transformerの視覚化 | Chapter 5, Deep Learning - YouTube

https://www.youtube.com/watch?v=KlZ-QmPteqM

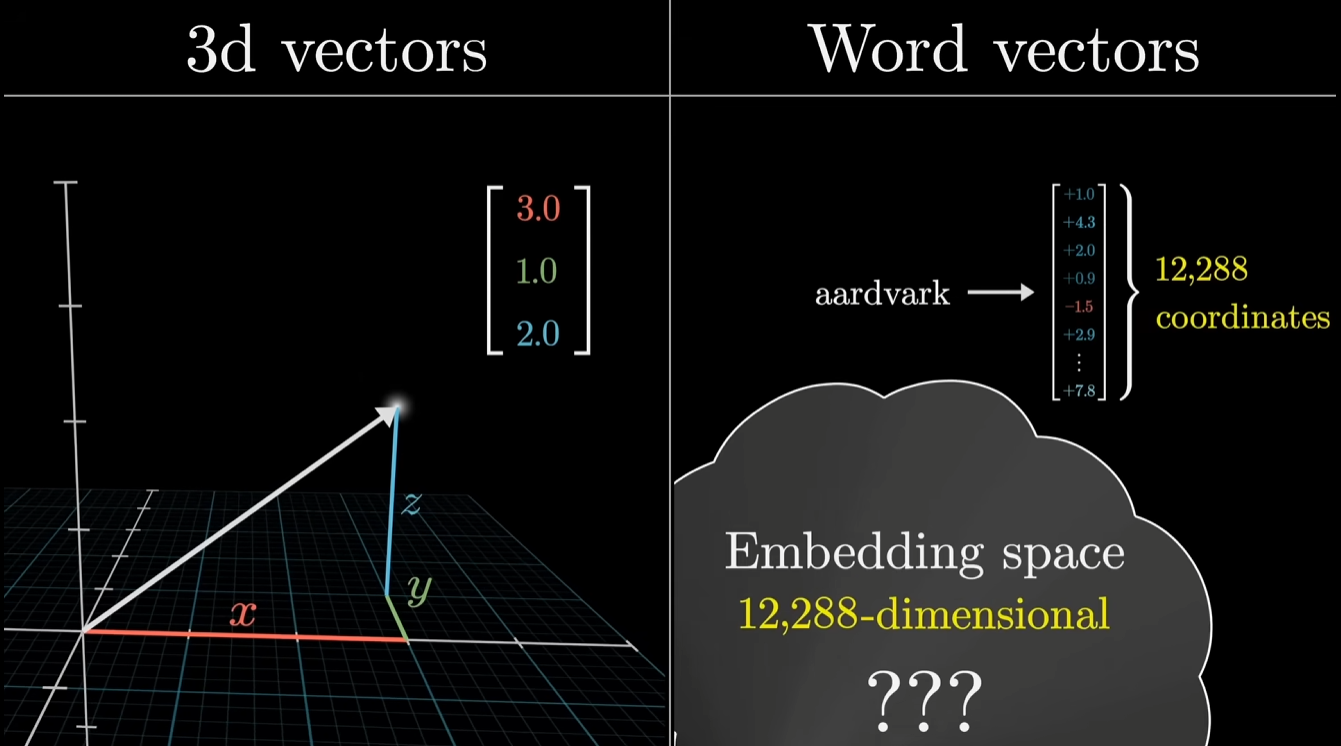

GPT3 では、単語 (トークン) ごとに 12,288 次元の意味を持たせるように事前学習されているらしい

単語が持つ「色」とか「大きさ」とか「怖い」とか「かわいい」などの意味を数値化したものを単語ごとに 12,288 種類用意してあり、これだけあれば言葉の持つ意味全てを収納できるってことらしく、すっげえなという感じ